レポート

2024.07.04(木) 公開

生成AIモデル比較ランキング: 最適な生成AIモデルを選ぶための詳細ガイド

1. はじめに

1.1. 比較サイトの紹介

Artificial Analysisは、生成AIモデルの品質、パフォーマンス、価格に関する詳細な比較と分析を提供するウェブサイトです。利用者が最適なモデルを選択できるよう、各モデルの出力速度、応答時間、コスト、コンテキストウィンドウの大きさなどを評価しています。このサイトには最新の生成AIモデルのデータが豊富に掲載されており、ユーザーがそれぞれのニーズに最適なモデルを見つけるための貴重なリソースとなっています。具体的な比較対象には、GPT-4o、GPT-4 Turbo、Gemini 1.5 Pro、Gemini 1.5 Flash、Claude 3.5 Sonnet、Claude 3 Haiku、Claude 3 Opus、Code Llamaなどが含まれています。

1.2. 比較の目的と重要性

生成AIモデルは、様々な分野で利用され、その性能やコストパフォーマンスは非常に重要です。高品質な生成タスクやリアルタイム応答、コスト重視のプロジェクト、長文処理・大規模データセットの処理など、用途に応じた最適なモデルを選ぶことが求められます。この比較レポートは、各モデルの特性を明確にし、ユーザーが自分のニーズに最適なモデルを選択するためのガイドラインを提供することを目的としています。具体的な指標としては、品質、出力速度、応答時間、価格、コンテキストウィンドウの5つのカテゴリで評価されます。

2. 総合評価のハイライト

2.1. 各モデルの総合評価と重要なポイント

このレポートでは、生成AIモデルの評価において以下のプロンプトオプションを条件としました。プロンプトの長さは100トークンであり、シングルクエリを使用しました。長いプロンプトの場合、一部のモデルやプロバイダーが表示されないことがあるため、標準的な約10,000入力トークンのコンテキストウィンドウが設定されています。また、モデルは利用頻度が高いと思われる「GPT-4o」、「GPT-4 Turbo」、「Gemini 1.5 Pro」、「Gemini 1.5 Flash」、「Claude 3.5 Sonnet」、「Claude 3 Haiku」、「Claude 3 Opus」、「Code Llama」を選択しています。

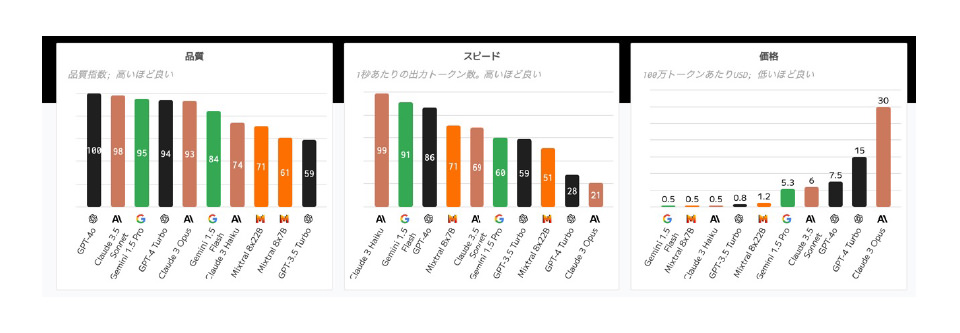

品質(Quality)

-

• トップモデル

GPT-4o (100)、Claude 3.5 Sonnet (98)、Gemini 1.5 Pro (95)

-

• 評価ポイント

高いほど良い品質を示します。GPT-4oは最も高い品質スコアを持っています。

出力速度(Speed)

-

• トップモデル

Claude 3 Haiku (99)、Gemini 1.5 Flash (91)、GPT-4o (86)

-

• 評価ポイント

1秒あたりの出力トークン数が多いほど高速です。Claude 3 Haikuは最も高速なモデルです。

価格(Price)

-

• トップモデル (低価格

Gemini 1.5 Flash (0.5 USD/100万トークン)、Claude 3 Haiku (0.5 USD/100万トークン)

-

• 評価ポイント

価格が低いほどコスト効率が良いです。Claude 3 Opusは最も高価です。

これらの評価を基に、次のセクションでは各指標ごとのランキングと詳細な分析を行います。

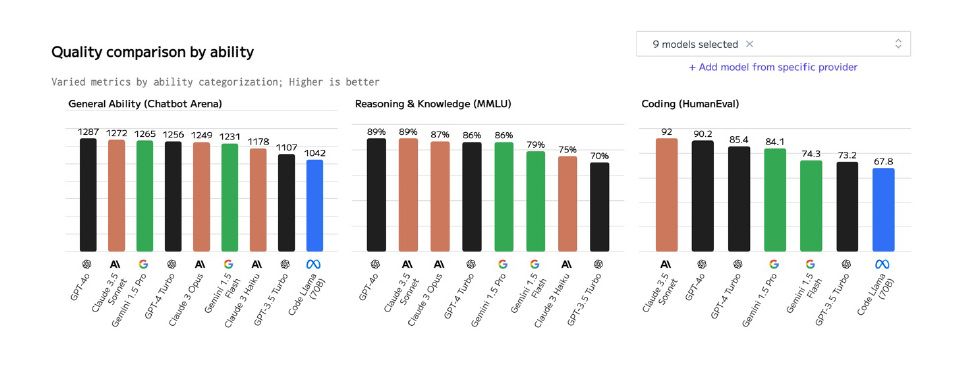

3. 品質比較

生成AIモデルの品質の比較結果は、以下の3つの能力別に評価しています。

一般的な能力(General Ability - Chatbot Arena)

-

• トップモデル

GPT-4o (1287)、Claude 3.5 Sonnet (1272)、Gemini 1.5 Pro (1265)

-

• 評価ポイント

高いスコアはより優れた一般的な対話能力を示します。GPT-4oが最高スコアを獲得しています。

推論と知識(Reasoning & Knowledge - MMLU)

-

• トップモデル

GPT-4o (89%)、Claude 3.5 Sonnet (89%)、Claude 3 Opus (87%)

-

• 評価ポイント

高いパーセンテージは優れた推論と知識の能力を示します。GPT-4oとClaude 3.5 Sonnetが同点でトップです。

コーディング(Coding - HumanEval)

-

• トップモデル

Claude 3.5 Sonnet (92)、GPT-4o (90.2)、GPT-4 Turbo (85.4)

-

• 評価ポイント

高いスコアは優れたコーディング能力を示します。Claude 3.5 Sonnetが最高スコアを獲得しています。

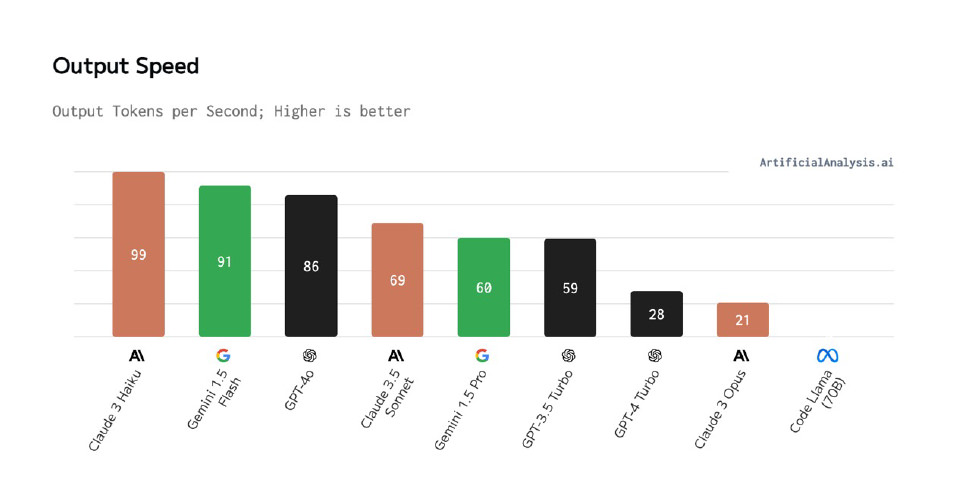

4. 出力速度比較

生成AIモデルの出力速度の比較結果は、以下の通りです。出力速度は、1秒あたりの出力トークン数で評価され、高い数値ほど高速です。

トップモデル

-

• Claude 3 Haiku: 99トークン/秒で、最も高速な出力速度を持っています。

-

• Gemini 1.5 Flash: 91トークン/秒で、非常に高速です。

-

• GPT-4o: 86トークン/秒で、トップ3にランクインしています。

詳細評価

-

• Claude 3.5 Sonnet: 69トークン/秒で中間に位置しています。高品質な生成タスクに適しています。

-

• Gemini 1.5 Pro: 60トークン/秒で安定した速度を提供します。コストパフォーマンスに優れています。

-

• GPT-3.5 Turbo: 59トークン/秒で比較的高速です。リアルタイム応答に適しています。

-

• GPT-4 Turbo: 28トークン/秒で低速ですが、高品質な出力を提供します。

-

• Claude 3 Opus: 21トークン/秒で最も低速ですが、特定のタスクでの有用性があります。

この評価は各モデルの処理速度を示しており、用途に応じたモデル選びの参考になります。

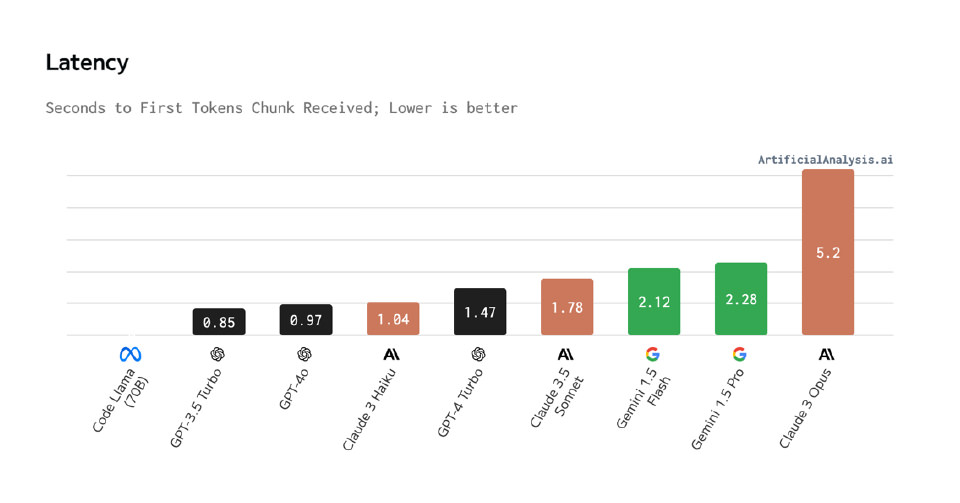

5. 応答時間比較

生成AIモデルの応答時間の比較結果は、以下の通りです。応答時間は、最初のトークンを受信するまでの秒数で評価され、低いほど優れています。

トップモデル

-

• GPT-3.5 Turbo: 0.85秒で、最も短い応答時間を持っています。

-

• GPT-4o: 0.97秒で、非常に迅速です。

-

• Claude 3 Haiku: 1.04秒で、高速な応答を提供します。

詳細評価

-

• GPT-4 Turbo: 1.47秒で、迅速な応答を提供します。

-

• Claude 3.5 Sonnet: 1.78秒で、比較的速い応答時間です。

-

• Gemini 1.5 Flash: 2.12秒で、迅速な応答が可能です。

-

• Gemini 1.5 Pro: 2.28秒で、安定した応答を提供します。

-

• Claude 3 Opus: 5.2秒で、最も遅い応答時間です。

6. 価格比較

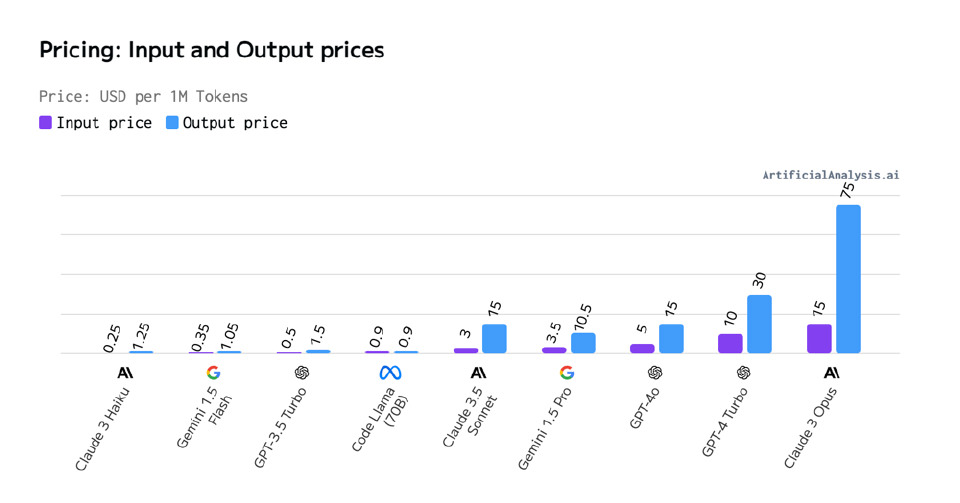

生成AIモデルの価格は、100万トークンあたりのUSDで評価されています。価格は、入力トークンと出力トークンのコストの合計です。以下に各モデルの価格比較を示します。

トップモデル(低価格)

-

• Claude 3 Haiku: 入力価格0.25 USD、出力価格1.25 USDで、最も低価格です。

-

• Gemini 1.5 Flash: 入力価格0.35 USD、出力価格1.05 USDで、非常にコスト効率が良いです。

-

• GPT-3.5 Turbo: 入力価格0.5 USD、出力価格1.5USDで、リーズナブルです。

詳細評価

-

• Code Llama (70B): 入力価格0.9 USD、出力価格0.9 USDで、比較的低価格です。

-

• Claude 3.5 Sonnet: 入力価格3 USD、出力価格1.5 USD。

-

• Gemini 1.5 Pro: 入力価格3.5 USD、出力価格10.5 USD。

-

• GPT-4o: 入力価格5 USD、出力価格10 USD。

-

• GPT-4 Turbo: 入力価格10 USD、出力価格20 USD。

-

• Claude 3 Opus: 入力価格15 USD、出力価格30 USDで、最も高価です。

7. コンテキストウィンドウ比較

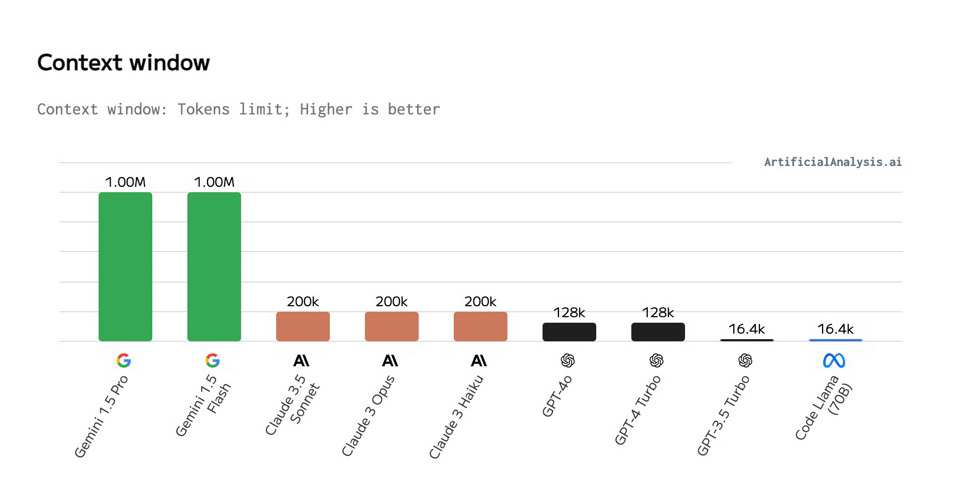

生成AIモデルのコンテキストウィンドウは、モデルが処理できるトークンの最大数を示しています。コンテキストウィンドウが大きいほど、より長いテキストを一度に処理できます。

トップモデル

-

• Gemini 1.5 Pro: 1,000,000トークンのコンテキストウィンドウを持ち、最も広範なテキスト処理が可能です。

-

• Gemini 1.5 Flash: 同じく1,000,000トークンで、高度なテキスト処理に適しています。

詳細評価

-

• Claude 3.5 Sonnet、Claude 3 Opus、Claude 3 Haiku: それぞれ200,000トークンのコンテキストウィンドウを持ち、長めのテキスト処理が可能です。

-

• GPT-4o、GPT-4 Turbo: 128,000トークンのコンテキストウィンドウ。

-

• GPT-3.5 Turbo、Code Llama (70B): 16,400トークンで、短いテキスト処理に向いています。

8. 用途別推奨モデル

生成AIモデルのコンテキストウィンドウは、モデルが処理できるトークンの最大数を示しています。コンテキストウィンドウが大きいほど、より長いテキストを一度に処理できます。

8.1. 高品質な生成タスク

高品質な生成タスクには、特に高精度で自然な文章生成が求められます。この用途には、以下のモデルが推奨されます。

-

• GPT-4o: 品質スコアが最も高く、幅広い生成タスクに対応。

-

• Claude 3.5 Sonnet: 高品質な生成能力を持ち、クリエイティブな文章作成に適しています。

8.2. リアルタイム応答

リアルタイム応答には、低レイテンシで迅速な応答が求められます。この用途には、以下のモデルが推奨されます。

-

• GPT-3.5 Turbo: 応答時間が短く、リアルタイムの対話に適しています。

-

• GPT-4o: 高速な出力速度と短い応答時間を持ち、即時の応答が必要な場面に最適です。

8.3. コスト重視のプロジェクト

コスト重視のプロジェクトには、経済的でありながらパフォーマンスが良いモデルが求められます。この用途には、以下のモデルが推奨されます。

-

• Gemini 1.5 Flash: 価格が非常にリーズナブルで、コストパフォーマンスに優れています。

-

• Claude 3 Haiku: 低価格でありながら高速な出力を提供。

8.4. 長文処理・大規模データセット

長文処理や大規模データセットの処理には、広範なコンテキストウィンドウを持つモデルが必要です。この用途には、以下のモデルが推奨されます。

-

• Gemini 1.5 Pro: 最大1,000,000トークンのコンテキストウィンドウで、長文や大規模データセットの処理に最適です。

-

• Gemini 1.5 Flash: 同じく1,000,000トークンのコンテキストウィンドウを持ち、効率的に長文処理が可能です。

9. まとめ

生成AIモデルの比較を通じて、各モデルの特性と用途に応じた推奨モデルが明確になりました。最後に、最適なモデル選択のポイントをまとめます。

9.1. 最適なモデル選択のポイント

1) 用途を明確にする

高品質な生成タスク、リアルタイム応答、コスト重視のプロジェクト、長文処理・大規模データセットなど、目的に応じてモデルを選びましょう。

2) 品質とパフォーマンスのバランス

GPT-4oやClaude 3.5 Sonnetは高品質な出力を提供しますが、価格も考慮する必要があります。

3) 応答時間と出力速度

リアルタイムの応答が必要な場合は、GPT-4oやClaude 3 Haikuのような低レイテンシのモデルが適しています。

4) コストパフォーマンス

予算に制限がある場合は、Gemini 1.5 FlashやClaude 3 Haikuなどの低価格モデルが推奨されます。

5) コンテキストウィンドウの大きさ

長文や大規模データの処理には、Gemini 1.5 ProやGemini 1.5 Flashのような大きなコンテキストウィンドウを持つモデルが最適です。

これらのポイントを考慮して、プロジェクトに最適な生成AIモデルを選択することで、効果的かつ効率的なAIソリューションを構築できます。

10. 参考文献

「ChatGPT導入・活用支援」はNOB DATAにご相談ください

ChatGPTの導入・活用に課題を感じていませんか?

NOB DATAでは、ChatGPT開発およびデータ分析・AI開発のプロフェッショナルが、多種多様な業界・課題解決に取り組んだ実績を踏まえ、ChatGPTの導入・活用を支援しています。社員向けのChatGPT研修も実施しており、お気軽にお問い合わせください。