レポート

2024.11.15(金) 公開

生成AIガイドラインの必要性について

目次

1. はじめに

2022年末頃からChatGPTが世間を賑わせ、それを皮切りに社内向けやサービスとして導入する企業が増えてきています。人間のようにチャットができたり、画像や音声、動画を生成してくれたりと正しく使うことができれば社内タスクの効率化や顧客に満足いただけるサービスを提供することができますが、一方で様々なリスクが伴います。

そのために必要となってくるのが、生成AIを正しく運用するためのガイドラインです。既に一部の組織では生成AIの運用におけるガイドラインを定めています。今回は、それらのガイドラインを参考にしつつ、どのようなことを定めるべきかを検討していきます。

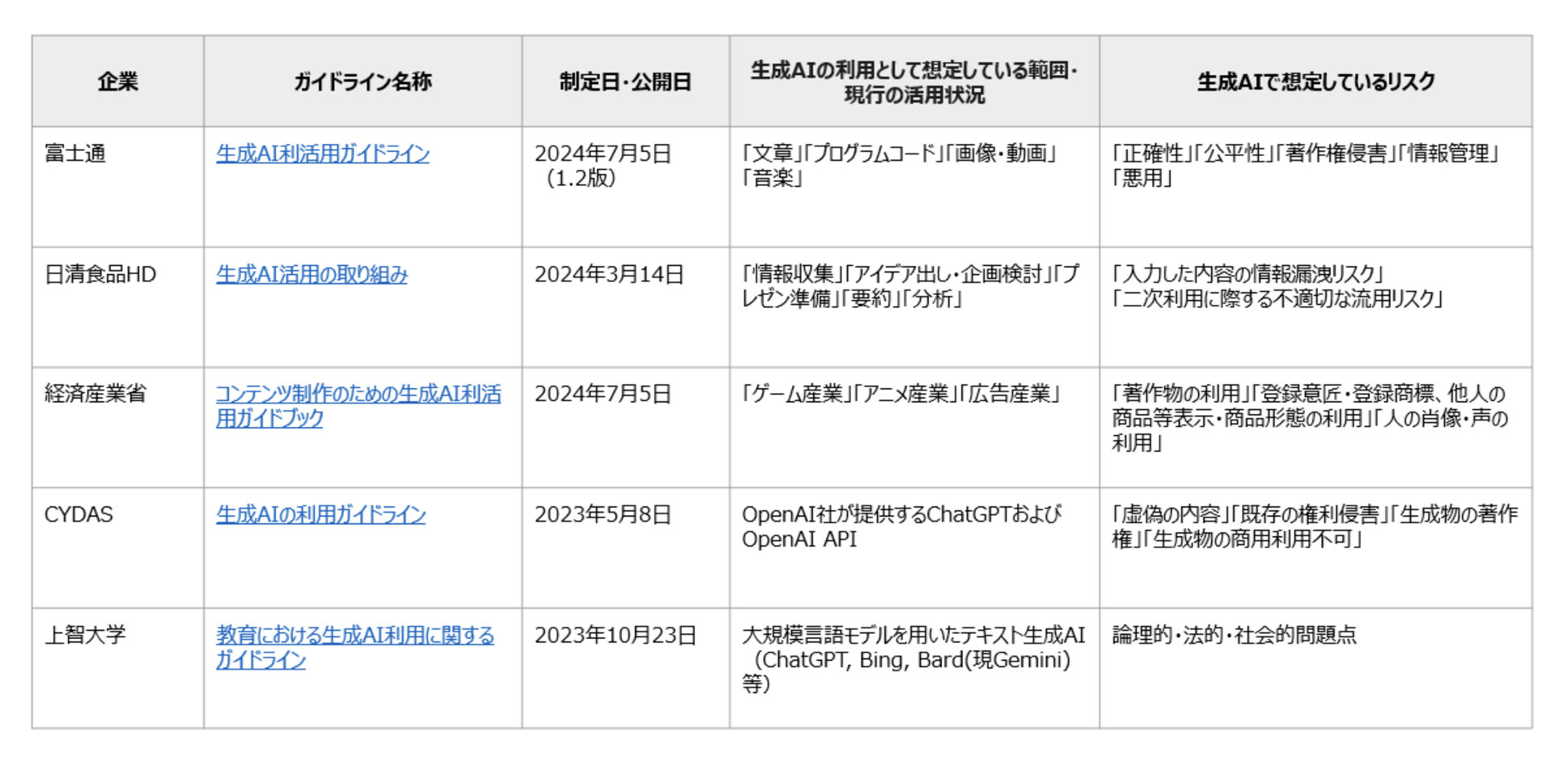

以下の図はガイドラインを定めている組織とガイドラインの概要をまとめたものです。

生成AIには様々なサービスや使用方法があります。

そのため、ガイドラインでは、組織内で利用を想定している範囲や現行の活用状況といった前提条件を定めた上で、生成AIに想定されるリスクについて記載されています。

また、そのリスクを最小化するためにすべきことの記載もあります。これをすることにより、生成AIを安全に利用することができます。

今回は上の図で紹介した3つの組織について、より詳細に解説していきたいと思います。

2. 個別組織のガイドライン紹介

1. 富士通株式会社

まずは、企業として富士通株式会社が作成しているガイドラインをご紹介します。こちらは富士通社員向けに制定されたガイドラインになります。

想定している生成AIの利用範囲としては、文章やプログラムコード、画像・動画、音楽について、人が創作したものの品質を向上させることから、コンテンツ自体を生成する部分までとしています。

例えば、「文章」であれば、文法のチェックや校正、要約、翻訳などベースとなる文章を生成AIに改良してもらう利用方法や、文章のアイデアを提案してもらったり、論文や物語そのものを生成してもらう利用方法があります。

これらを利用することで考えられるリスクについては、「正確性」「公平性」「著作権侵害」「情報管理」「悪用」の5つを挙げています。この5つのリスクは、生成AIに指示を与えるインプットの時点と生成物を使用するアウトプットの時点の大きく2つに分けられており、「情報管理」についてはインプット、それ以外の4つ(「正確性」「公平性」「著作権侵害」「悪用」)についてはアウトプットを使用する際に想定されるリスクとなっています。

「情報管理」についてのリスクは、生成AIに入力する内容が生成AIの提供元や他の利用者へ情報漏洩を引き起こす可能性があります。よって、秘密情報や個人情報は生成AIに入力しないように注意が必要です。

一方で、アウトプットに関するリスク(「正確性」「公平性」「著作権侵害」「悪用」)については、生成AIが作成する創作物に、誤りや偏った結果、著作権を侵害するようなものが出力される可能性があります。また、このように誤りや偏りがある生成物を大衆に流してしまうことで、大衆がそれを信じてしまう可能性もあります。

これらを防ぐためには、生成AIが作成した生成物を使用する前に、我々人間の目で確認をする必要があります。

2. 経済産業省

次に紹介するのは、経済産業省が公開しているコンテンツ制作者にむけた生成AI活用のガイドラインです。

生成AIを使って作成できるコンテンツは様々ありますが、ここで事例としてあげられているのは「ゲーム産業」「アニメ産業」「広告産業」の3つになります。

リスクとしては「著作物の利用」「登録意匠・登録商標 、他人の商品 等表示・商品形態の利用」「人の肖像の利用」「人の声の利用」の4点について主にあげられています。

この4点ですが、言い方を変えると、生成AIを活用した作成物が著作権や意匠権、商標権、肖像権やパブリシティ権の侵害の可能性についてことを述べています。事例としてあげているコンテンツについては、人物の肖像や声が出てくるものもありますので、特に注意が必要になります。また、その他留意点という形で、「入力された個人情報」「誤情報やハルシネーション(もっともらしい嘘)が生成される可能性」等についても記載があります。

このリスクを避けるためには、生成AIにインプットする段階で他人の著作物や特定の登録意匠、登録商標、人物に関連するようなプロンプトを入力しないことが重要です。また、生成AIによる作成物がこれらと同一、類似している場合は、権利者から承諾を得るか利用を避ける必要があります。権利侵害について判断が難しいと思いますので、過去の判例や裁判例を判断基準にして検討するという方法もあります。

3. 上智大学

最後に紹介するのは、上智大学が教職員向けに制定したガイドラインになります。

教職員が学生に向けて、各授業で生成AIの使用可否を伝えたうえで、必要があれば方針の意図や使用できる範囲を説明することを徹底させるものになります。

使用の範囲として例であげられていたものは、「授業課題で使用することは禁止。一方でブレインストーミングなどについては有用があるため、利用を許可する。」というものがありました。ここで出てくる使用方法としては、前述している2つの組織のガイドラインでも述べられている「個人情報等の機密情報は入力しない」「生成物については参考書や文献と照らし合わせながら使用する」ということが記載されています。

また、学生が生成AIを使用して授業課題やレポート等を作成してしまうという場面も想定されており、この際の確認手順についてもガイドラインに記載がされています。教育現場においては、生成AIを使用してもよい範囲を明確に定めることと、学生自らが生成AIについて学んでいく状態を作ることが重要だと感じます。

3. まとめ

今回は、それぞれ違った観点で生成AI利用におけるガイドラインを制定している組織を3つ紹介しました。表現の仕方は各ガイドラインによって様々でしたが、どの組織でもリスクとしてあげられているのは大きく分けて以下3つになります。

個人情報や機密情報の流出

権利の侵害(著作権、登録意匠、登録商標、肖像権など)

生成物の精度(ハルシネーション)

「1.個人情報や機密情報の流出」については、プロンプトで入力をしないことが重要です。一方で、サービスによってはプロンプトに入力した情報が学習に利用されないとしているものもありますので、使用するサービスを正しく理解しておく必要があります。

また、「2.権利の侵害」「3.生成物の精度」については、生成AIから作成されたアウトプットを必ず確認することが重要になります。

生成AIは私たちの生活を豊かにしてくれるツールです。一方で、今回あげたリスクも存在します。ガイドラインを制定することでリスクを最小限に抑え、生成AIについてのリテラシーをあげていくことにもつながります。

皆様が所属する組織でも生成AIの利用におけるガイドラインを制定を考えているということがありましたら、ぜひ一度NOB DATAにご相談ください。

「ChatGPT導入・活用支援」はNOB DATAにご相談ください

ChatGPTの導入・活用に課題を感じていませんか?

NOB DATAでは、ChatGPT開発およびデータ分析・AI開発のプロフェッショナルが、多種多様な業界・課題解決に取り組んだ実績を踏まえ、ChatGPTの導入・活用を支援しています。社員向けのChatGPT研修も実施しており、お気軽にお問い合わせください。